Nach dem Überblick zur BDC aus dem ersten Blogbeitrag, fokussiert dieser zweite Blogbeitrag die Rolle der Plattform SAP Databricks. Sie erweitert und ergänzt die BDC um ein Data-Lakehouse für die Integration und das Data-Engineering von SAP- und Non-SAP-Daten sowie um GenAI- / ML-Modelle und Serverless-SQL für die Echtzeitanalyse.

Für Unternehmen, die SAP-Software wie SAP S/4HANA (Cloud) einsetzen, kann der Zugriff auf SAP-Daten auch mit modernen Analytics– und KI-Tools mitunter komplex sein. Die Daten müssen häufig aufwendig in externe Plattformen exportiert, dort bereinigt, transformiert und speziell im Fall von Plandaten wieder zurück übertragen (ETL-Prozess) werden. Da zugleich Non-SAP-Lösungen genutzt werden, sind auch diese Daten für Analysen verfügbar zu machen.

Die negativen Folgen sind bekannt: Die Daten sind redundant und inkonsistent sowie zum Zeitpunkt der Analyse meist veraltet, was Data-Governance-Risiken birgt. Und durch die zeitaufwendigen ETL-Prozesse dauert auch die Erstellung von Custom-KI-Anwendungen oft Wochen, und nicht selten Monate. Die zentrale Frage ist daher, wie eine in die SAP-Landschaft integrierte einheitliche Datenhaltung für Analytics- und KI- / ML-Szenarien gelingt. Die passende Antwort darauf bietet SAP mit der modularen SaaS-Lösung SAP Business Data Cloud (SAP BDC) als Datenökosystem.

SAP Databricks: Data-Lakehouse für alle Datentypen

Eine Kernkomponente der BDC ist SAP Databricks, eine speziell für diese SaaS-Lösung angepasste Version der Databricks-Plattform für Data Engineering, Data Science, Datenaufbereitung und Analyse. Ihre offene und leistungsstarke Data-Lakehouse-Architektur ermöglicht die Integration aller Arten von Daten: von strukturierten Daten aus SAP- und Non-SAP-Software sowie von unstrukturierten aus IoT-Lösungen, E-Mails oder PDF-Dateien.

Der entscheidende Unterschied zu bisherigen Integrationsansätzen liegt im „Zero-Copy“-Verfahren per Delta Sharing. Live-Daten aus SAP-Datenprodukten, Custom-Datenprodukten beispielsweise aus BW-Daten, Non-SAP-Systemen und externen Quellen lassen sich so ohne physisches Kopieren in SAP Databricks für Analytics und KI bidirektional verfügbar machen und einheitlich verwalten – Stichwort „Single Source of Truth“. Die SAP-Datenprodukte müssen aber aktiviert sein, damit automatisch ein Delta Share erstellt wird und um sie in den Unity Catalog von SAP Databricks einzubinden.

Unity Catalog für zentrale Data Governance

Als Data-Governance-Tool und zentrales Repository vereinheitlicht der Unity Catalog die Verwaltung von Daten, KI-Assets und Analytics über verschiedene Clouds und IT-Systeme hinweg. Den sicheren, nachvollziehbaren Datenzugriff gewährleisten Funktionen für zentrale Zugriffssteuerung, Auditing, Datenherkunft und -übermittlung sowie eine dreistufige Hierarchie (Katalog, Schema, Tabelle).

KI-gestützte Datenanalysen „out of the box“

All das ermöglicht Data-Science-Analysen quasi „out of the box“. SAP Databricks bietet dafür schlagkräftige Data-Science-, Data-Engineering- und ML / KI-Funktionen sowie mit Mosaic AI ein Framework zur Entwicklung individueller KI-Lösungen und -Agenten, die direkt auf Geschäftsdaten trainiert werden. Notebooks vereinfachen das Erstellen von Custom-KI- / ML-Lösungen und von Data-Engineering-Aufgaben durch vollständig verwaltete Workflows.

Darüber hinaus lassen sich in SAP Databricks Ad-hoc-Explorationen in SAP-Datenprodukten, skalierbare Serverless-SQL-Echtzeitabfragen mit interaktiven Dashboards und Analysen per Data-Stream-Processing auf kontinuierliche Datenströme durchführen, wie sie etwa IoT-Sensoren liefern.

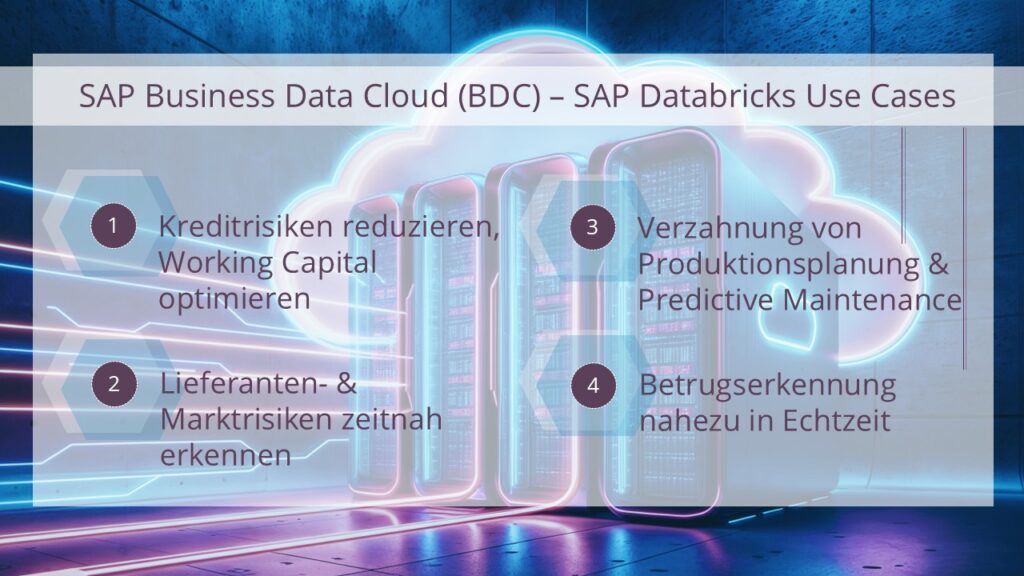

Use Cases mit geschäftlichem Mehrwert

Die Integration von SAP Databricks in die BDC eröffnet neue Möglichkeiten, Daten aus SAP-Systemen (SAP Data Products), Non-SAP-Lösungen und sonstigen externen Quellen zu verknüpfen und effizient zu nutzen. Den geschäftlichen Nutzen zeigen folgende Anwendungsfälle (Use Cases) auf, wie in der Abbildung zu sehen:

1. Kreditrisiken reduzieren, Working Capital optimieren

Die exakte Bewertung von Kreditrisiken ist geschäftskritisch. Da sich mit SAP Databricks Zahlungsströme, offene Posten und Vertragskonditionen aus SAP mit externen Bonitäts- und Finanzdaten sowie Daten aus sozialen Medien kombinieren lassen, kann das Zahlungsverhalten anhand von KI-Analysen zuverlässig prognostiziert werden. Risikobehaftete Kunden und Lieferanten werden somit schnell erkannt und in Folge Ausfallrisiken und Forderungsverluste reduziert, was das Nettoumlaufvermögen (Working Capital) erhöht.

2. Lieferanten- und Marktrisiken zeitnah erkennen

Lieferketten reagieren störanfällig auf Marktveränderungen und geopolitische Ereignisse und können reißen. Werden Kreditratings, Finanzberichte und Zahlungshistorien von Lieferanten mit SAP Databricks KI-gestützt laufend überwacht und bewertet, erhält man eine klare Sicht auf ihre finanzielle Stabilität und kann ein proaktives Risikomanagement etablieren, um Brüche in der Supply Chain zu vermeiden.

3. Verzahnung von Produktionsplanung und Predictive Maintenance

Durch die Kombination von KI-/ML-Modellen aus SAP Databricks mit SAP Datasphere und SAP Analytics Cloud lassen sich Produktionsplanung und vorausschauende Instandhaltung verzahnen. Dadurch ist es möglich, in einem einzigen Dashboard Fertigungspläne mit IoT-Daten zu verknüpfen und so eine Echtzeitsicht auf den Zustand von Maschinen zu liefern. Damit kann ihre Ausfallwahrscheinlichkeit exakt prognostiziert werden und Wartungen lassen sich gezielt planen. Das reduziert Stillstandzeiten, spart Reparaturkosten, verlängert die Lebensdauer der Anlagen und verbessert im Ergebnis die Betriebseffizienz und die Rendite des Anlagevermögens.

4. Betrugserkennung nahezu in Echtzeit

In der Finanz- und Versicherungsbranche lassen sich durch automatisierte KI-Analysen von Transaktions- und Kundendaten mit SAP Databricks verdächtige Aktivitäten oder Betrugsversuche umgehend erkennen und finanzielle Schäden deutlich begrenzen.

Genau deshalb ist SAP Databricks mehr als ein weiteres Analytics-Tool in der SAP Business Data Cloud (BDC)

All das zeigt: Mit der Integration von SAP Databricks in die BDC erhalten Unternehmen wichtige Hebel, um die Effizienz, Sicherheit und Resilienz ihrer Prozesse zu erhöhen und eine digitale Datenstrategie zu realisieren, aus der sie vielfältigen geschäftlichen Mehrwert ziehen können.

Davon profitieren auch Firmen, die SAP-Cloudlösungen wie SAP S/4HANA Cloud (Public/Private Edition) oder SAP SuccessFactors nutzen und die BDC einführen wollen, aber bereits eine Databricks-Lösung in der Cloud betreiben. In absehbarer Zukunft wird es möglich sein, die eigene Databricks-Instanz direkt in die BDC zu integrieren, was bestehende Investitionen schützt und Mehrkosten vermeidet.

Schon gewusst? Unsere SAP- und ORBIS-Referenten führen Sie praxisnah und unkompliziert in das Thema SAP Business Data Cloud (BDC) & KI ein: